На днях поисковик Google прислал мне поздравления с тем, что сайт Webhamster.Ru достиг крупного показателя: количество переходов с поисковика Google достигло 100 000 переходов в месяц. Не сказать, чтобы я как-то специально занимался сайтом, чтобы увеличивать количество переходов. Честно говоря, меня такие вещи вообще не интересуют. Мне достаточно знать, что количество переходов, в частности, зависит от качества сайта и качества размещенной на нем информации. За этим я постоянно слежу как на страницах самого сайта, так и на страницах раздела MyTetra Share.

В общем, Google считает Webhamster.Ru достойным сайтом:

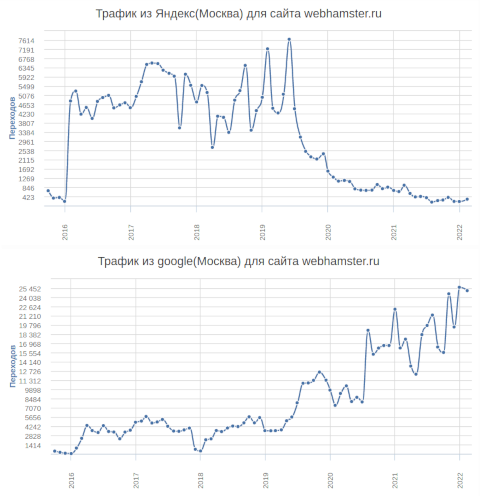

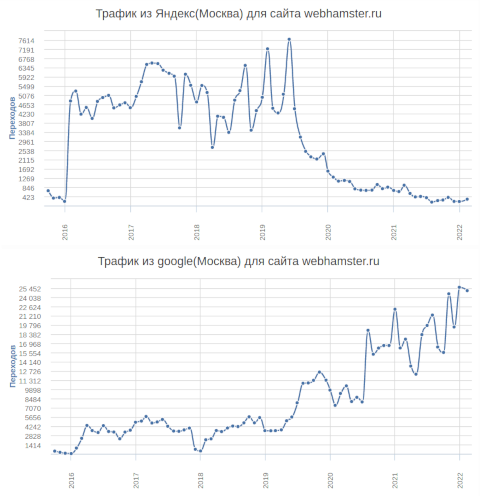

Но интересно в этом достижении не сам его факт, а кое-что другое. Дело в том, что если посмотреть анализ изменения поисковой выдачи Google по сравнению с Яндекс, то окажется, что зависимость во времени у этих двух поисковиков обратно-пропорциональная. Вот пример выдачи моего сайта в результатах поиска в городе Москва (сверху Яндекс, снизу - Google):

Видно, что Яндекс в период с середины 2019 года до текущего момента по каким-то причинам методично снижает степень поисковой выдачи. В то время как Google на тех же данных методично повышает. Почему так происходит - совершенно непонятно. Видимо, алгоритмы ранжирования двух этих крупных поисковиков настолько разные и неуправляемые, что становится непонятно, что же на самом деле хорошо для поиска: структурирование контента? Поведенческие факторы? Что-то еще?

У Яндекса уже несколько лет идет чехарда с зеркалами сайтов. Например, если сайт отвечает и по протоколу HTTP и по протоколу HTTPS, да еще и DNS настроен на возможность отвечать на запросы имени с префиксом www, то Яндекс никак не может определиться что же считать главным зеркалом сайта. Ручное указание главного зеркала приводит к тому, что в консоль вебмастера бесконечно сыпятся предупреждения о том, что по мнению Яндекса https://имя_сайта не является главным зеркалом, и страницы, найденные по другим протоколам являются основными, а на протоколе https - дубликатами. Обращение в техподдержку ни к чему не приводит - говорят, что это нормально, и скоро система сама переключится. Но проходит куча времени, и ничего не меняется.

Кроме того, Яндекс очень странно индексирует сайт: в консоли вебмастера отображается более 12 тыс. страниц (и это близко к истине). И до некоторого времени это же число отображалось и в поисковой выдаче Яндекса при запросе site:webhamster.ru. Но с какого-то момента Яндекс вдруг стал считать, что на сайте расположено всего 2 тыс. страниц: "Нашлось 2 тыс. результатов". Куда Яндекс потерял 10 тыс. страниц с уникальным контентом - это большая загадка природы.

Я раньше краем уха слышал разговоры веб-мастеров о том, кто под какие поисковики затачивает свои сайты. И я не предавал этим разговорам особого значения. Зачем заниматься какой-то подгонкой, если гораздо важнее содержание сайта в таком виде, каком считаешь более правильным? На практике оказалось, что действительно, поисковик поисковику рознь; и даже всего у двух систем может быть диаметрально противоположное мнение по одному и тому же контенту.

Поиск по сайту

Поиск по сайту